トップページ |

ひとつ上のページ |

目次ページ |

このサイトについて |

ENGLISH

トップページ |

ひとつ上のページ |

目次ページ |

このサイトについて |

ENGLISH

トップページ |

ひとつ上のページ |

目次ページ |

このサイトについて |

ENGLISH

トップページ |

ひとつ上のページ |

目次ページ |

このサイトについて |

ENGLISH

統計的な検定と、統計教育の歴史 にあるように、「『P値0.05』を判断の根拠にするのは不適切」という理解が、徐々に浸透して来ています。

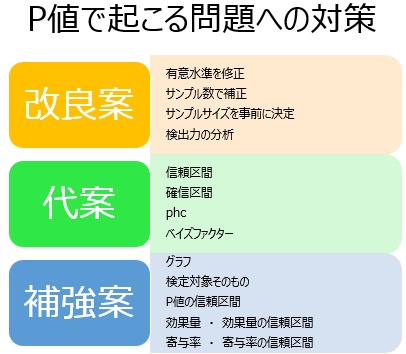

そこで、P値の改良案・代案・補強案が、いろいろと提案されて来ています。 このページは、筆者が今までに出会った案について、整理したものです。

以下は、平均値の差の検定を念頭に置いて説明していますが、他の検定でも同様です。

P値が起こす問題点に対して、P値の計算方法や、使い方を改良しようとする案があります。

発想がシンプルなのが良いところですが、どれも解決策にはなり切れていないものと、筆者は考えています。

「P値0.05」が標準的な指標になっていますが、これを「P値0.01」や「P値0.005」というようにして、さらに小さな値にするアイディアです。

スモールデータの検定の効果量 のページにあるように、「P値0.05」という基準は、サンプル数が少ない時には、根拠を持っています。

ところが、サンプル数のことを抜きにして、P値の大きさを議論し始めると、根拠がなくなってしまいます。

また、単純にP値を小さくすると、十分過ぎるくらい差があっても、「差があるとは言えない」という結論になりやすくなります。

「P値のサンプル数への影響を修正しよう」という考え方があります。 この方法がうまく行けば、「P値0.05」という判定方法が、サンプル数に関係なく適用できます。

「P値に、サンプル数をかける」、「P値にサンプル数の2乗をかける」といった案があるようですが、数理的な根拠はないようです。

この案も、そもそもサンプル数が多いとP値が小さくなりやすいことの理由については踏み込まずに、対策を出しています。

「P値には、サンプルサイズに依存してしまうので問題が起きる」という点については、「サンプルサイズの決定を事前にやっておけば、問題が起きない」という考え方があります。 サンプル数を固定する統計学 として、ひとつの手法になっています。

このアプローチが使えるのは、実験をして、新しくデータを得る場合になります。 データが既にあるところから始まるテーマでは、使えないです。

また、多くのデータを取ることが簡単なら、多く取る方が確実な結果が出せるはずですが、この方法は、あえて少ない数のデータを要請することになります。 そのため、不自然な理屈の方法論になっています。

P値による分析への問題点として、「P値は検証に十分な大きさだとしても、 検出力 が不十分な研究が多い」という指摘が見受けられます。

この指摘は、「どんな検定でも、検出力の算出ができるし、検出力の分析が必要」という前提がありますが、 2種類の対立仮説を混同しているため、この前提は誤解です。

検出力が算出できるテーマなら、算出すべきですが、筆者の経験では、算出できないテーマの方が一般的です。

P値の代案は、「これからはP値ではなく、こちらを使うべき」というようにして説明されます。 P値の代案として、信頼区間、確信区間、phc、ベイズファクターがあります。

これらは、アプローチがP値と大きく異なりますが、平均値の差の分布を議論する点が同じなので、サンプル数が多い時の性質がP値と同じになります。 そのため、代案にはなり切れていないものと、筆者は理解しています。

なお、P値が引き起こす問題への対策にはなっていないものの、アプローチが違うので、分析できることは違っています。

単に「信頼区間」と呼ぶときには、「平均値の差の信頼区間」という意味です。

P値による分析では、ひとつの値だけを使って考察することに対して、信頼区間による分析では、範囲(区間)を使った考察になります。

P値と信頼区間の関係 のページに、やや詳しく書きましたが、P値と信頼区間は、実質的に同じ分析なので、対策にはなっていないです。

信頼区間による方法への対策として説明されることがあるのが、 確信区間 を使う方法です。 ベイズ統計学 を基盤にしています。

確信区間との違いは、「平均値の差」との関係を定量化する点です。

ベイズ統計学 を基盤にする方法としては、 ベイズファクター もあります。

ベイズファクターには、フィッシャー流の対立仮説のテーマに対して、ネイマン・ピアソン流の解き方ができるように工夫された方法もあり、検定の新しい可能性を示しているものと、筆者は考えています。

しかし、ベイズファクターには、根拠のある目安がないため、実用的ではないです。 また、サンプル数が多い時の性質がP値と似ています。

P値は、それ自体は間違った指標でも、問題のある指標でもないです。 問題があるのは、P値を使う人の理解不足です。

改良案や代案ではなく、P値ではわからないことを調べようとする補強案もあります。

これらは、 21世紀の検定 にも入っています。

平均値の差の検定をする場面は、そもそも平均値が同じかどうかを知りたいのではなく、2つのグループの分布が同じかどうかを知りたいことが多いです。 これは、グラフを見れば、結果は一目瞭然なことが、よくあります。

1次元散布図、ヒストグラム、箱ひげ図 などを使って、データを実際に見ます。

外れ値やデータの偏りによって、P値が影響されることがあります。 そのような時に、グラフは、P値の補助的な手段にもなります。

因果関係の分析で、平均値の差の検定を使う場合は、「平均値の差」が検定対象です。

筆者にも経験があるのですが、「2つのグループの違いを調べたい時は、平均値の差の検定」という理解をしていると、 「平均値の差は、いくつなのか?」ということを、まったく気にせずに、P値の値ばかり気にしていることがあります。

平均値の差について、 差の意味で検定を補強 すると、より強い検定になります。

ちなみに、因果推論の分野では、平均値の差は、「 因果効果 」と呼ばれています。

また、心理学関係では、平均値の差を、効果量の一種として説明していることがあります。

P値と信頼区間の両方のアイディアを併せ持った「 P値の信頼区間 」というものがあります。

サンプルサイズが小さい時は、P値の信頼区間はそれなりに大きいです。 そのため、サンプルサイズが小さい時の補助的な指標になります。

効果量による判断は、平均値の差の具体的な値と、データのばらつきの関係を見ます。

グラフで見えることを、数字で示す方法としても使えます。

効果量と信頼区間の両方のアイディアを併せ持った「 効果量の信頼区間 」というものがあります。

従来の信頼区間は、例えば、平均値の差の信頼区間のことですが、研究の目的とミスマッチを起こしています。 確信区間でも同様です。

効果量は、研究の目的と合う指標になるのですが、効果量の確からしさがわからないです。

効果量の信頼区間は、効果量だけでなく、その確からしさもわかるようになっています。 サンプル数が少ないと、範囲が広くなり、多いと、狭くなります。

効果量も、信頼区間も、第一線の研究者の間で、「使うべき」という認知がある程度広まっています。 そのため、効果量の信頼区間は、今後、有望な方法として、受け入れられやすいものと思います。

寄与率は、古くからある指標ですが、「P値を見れば良い」という認識が定着してしまったせいか、統計学の解説ではあまり見かけません。

P値が重宝された理由のひとつとして、「0から1の値になるので、判断の指標にしやすい」という点があると思うのですが、この良さが効果量にはありません。

寄与率には、効果量にはない良さがあります。

「寄与率の信頼区間」というのは、おそらく誰も必要として来なかったものですが、 効果量の信頼区間 が必要とされるのと同じ理由で、寄与率を計算するのなら把握しておきたくなります。

順路

次は

差の意味で検定を補強

次は

差の意味で検定を補強